Robots.txt 파일 만드는 방법, 업로드 및 수정 방법 그리고 이 파일을 사용하는 이유와 자주 사용되는 규칙 예시들에 대해서 알아보겠습니다. 워드프레스에 robots.txt 파일이 있으면 좋지만 없어도 크롤링 및 인덱싱에는 문제가 없습니다. 다만, 더 빠른 색인과 SEO 최적화를 위해서 활용하는 게 좋습니다. Robots.txt에 대해서 자세하게 알고 싶은 신 분들은 순서대로 읽어 주시면 됩니다. robots.txt 만드는 방법 및 수정 방법만 확인하실 분은 아래 본문 바로가기로 이동하시면 됩니다.

Robots.txt 규칙 및 예시(사용법 및 설정 방법)

Robots.txt는 허용(allow)과 차단(disallow)으로 크게 나눌 수 있습니다. 사이트 유형에 맞게 크롤링을 선택적으로 제한하거나 허용하는 다양한 규칙들이 있습니다. 아래에서 일반적으로 자주 쓰는 규칙들과 예시를 알아보겠습니다.

검색 엔진 봇(크롤링 봇) 이름 모음

| 검색 엔진 | 봇 이름 |

| 구글 (Google) | Googlebot |

| 빙 (Bing) | Bingbot |

| 네이버 (Naver) | Yeti |

| 다음 (Daum) | Daumoa |

| 야후 (Yahoo) | Slurp |

| 바이두 (Baidu) | Baiduspider |

| 페이스북 (Facebook) | FacebookExternalHit |

| 트위터 (Twitter) | Twitterbot |

Robots.txt 표준 규칙

| 규칙 | 내용 |

| user-agent: | 검색 로봇 지정 또는 식별 |

| allow: | 접근 허용(크롤링 허용) |

| disallow: | 접근 차단(크롤링 차단) |

| sitemap: | 사이트맵의 경로 |

| / | 경로 지정 |

| # | 주석 용도 |

Robots.txt 예시 모음

모든 크롤링 봇 허용

| user-agent* | 모든 봇 허용 |

틍정 봇 허용 및 차단 규칙 예시

| 베리 봇 크롤링 허용 | 베리 봇 크롤링 차단 |

| user-agent: berrybot disallow: | user-agent: berrybot disallow: / |

특정 봇 허용 및 차단 예시 (다수)

| 베리 봇만 허용, 그 외 차단 | 베리 봇만 차단, 그 외 허용 |

| user-agent: berrybot allow: / user-agent:* disallow: / | user-agent: berrybot disallow: / user-agent:* disallow: |

모든 문서 접근 허용 및 차단 예시

| 모든 문서 접근 허용 | 모든 문서 접근 차단 |

| user-agent: * allow: / | user-agent: * disallow: / |

특정 폴더 및 파일 차단 예시

| 베리폴더 및 예하 차단 | 특정 파일만 차단 |

| user-agent: * disallow: /베리폴더/ | user-agent: * disallow: /베리파일.txt/ |

특정 확장자 차단 예시

| PNG파일 접근 차단 | SVG, PNG파일 접근 차단 |

| user-agent: * disallow: /* .png$ | user-agent: * disallow: /* .png$ disallow: /* .svg$ |

여러 그룹 개별 설정 예시

| 봇 별 개별 설정 | 봇 별 개별 경로 설정 |

| user-agent: 가 disallow: / user-agent: 나 disallow: | user-agent: 가 disallow: /가 user-agent: 나 disallow: /나 |

더 많은 예시는 여기에서 확인 가능합니다.

Robots.txt 실시간 테스트 방법

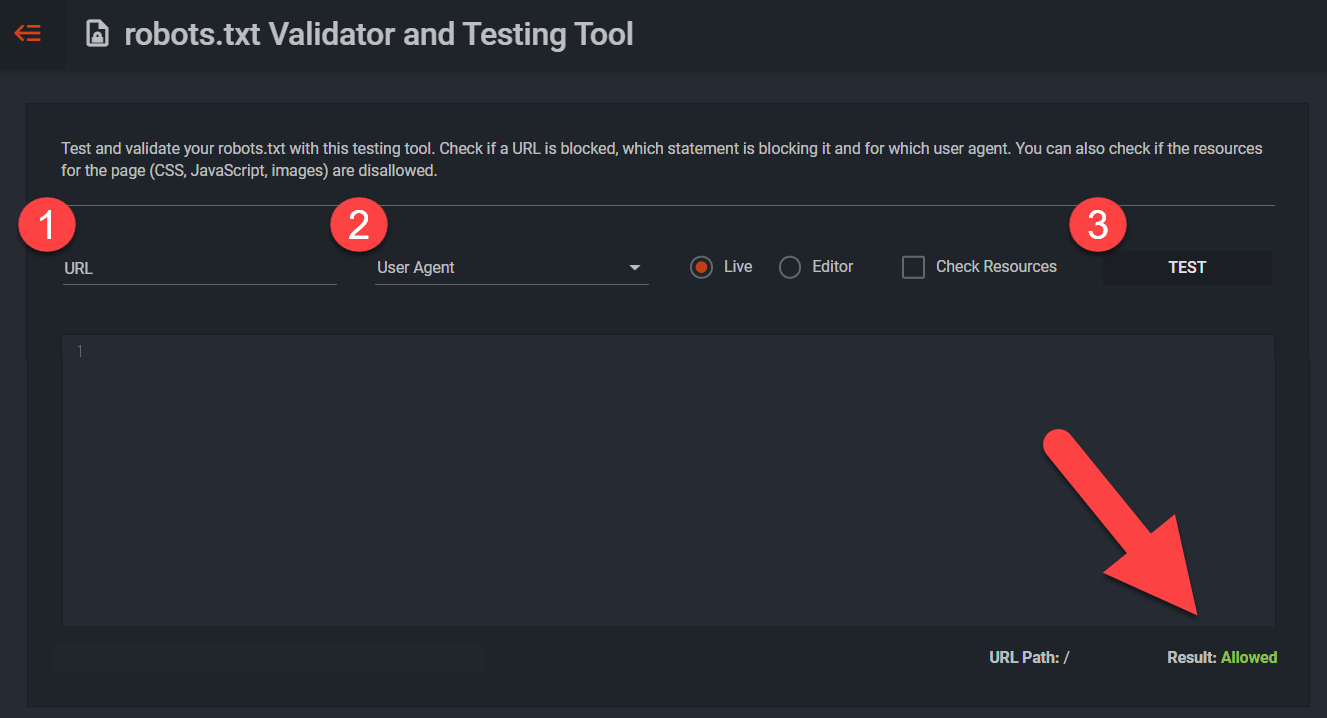

설정 후 “Techicalseo 사이트“에서 정상적으로 작동 중인지 실시간으로 확인이 가능합니다.

① 사이트 도메인을 입력합니다.

② 검색 엔진 봇을 선택합니다.

③ [TEST]를 눌러 테스트를 실행합니다. Result에서 허용 및 차단 여부를 확인합니다.

워드프레스 robots.txt 생성 유무 확인 방법

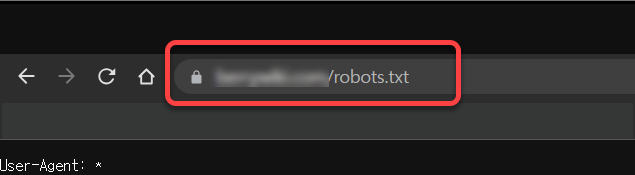

robots.txt 설치 및 수정 전, 내 사이트에 파일이 업로드 되어있는지 어떤 규칙으로 되어있는지 간단하게 확인할 수 있는 방법입니다.

[https://도메인/robots.txt]를 주소창에 입력하면 확인이 가능합니다.

워드프레스 Robots.txt 업로드 2가지 방법

워드프레스에 Robots.txt를 업로드하는 2가지 방법을 아래에서 알아보겠습니다.

FTP 방식으로 수동 업로드를 진행할 경우, 플러그인을 설치할 필요가 없습니다. 플러그인을 사용하면 간단하게 파일 생성 및 수정이 가능하나 플러그인을 설치해야 됩니다. 파일질라 사용 방법이 익숙하지 않으신 분은 플러그인을 사용하시는 것을 추천드립니다.

(수동 업로드 방식 또는 플러그인 사용 방식 중 하나만 택해서 진행해주시면 됩니다. )

Robots.txt 만드는 방법(파일질라, FTP업로드)

FTP(File Transfer Protocol)는 인터넷을 통한 파일 전송 수단입니다. 파일질라(FileZilla)는 FTP 소프트웨어 중 가장 많이 사용되는 무료 소프트웨어입니다. 파일질라를 활용해서 워드프레스 수동 설치, 백업 파일 업로드, 코드 수정 등 다양하게 활용이 가능합니다.

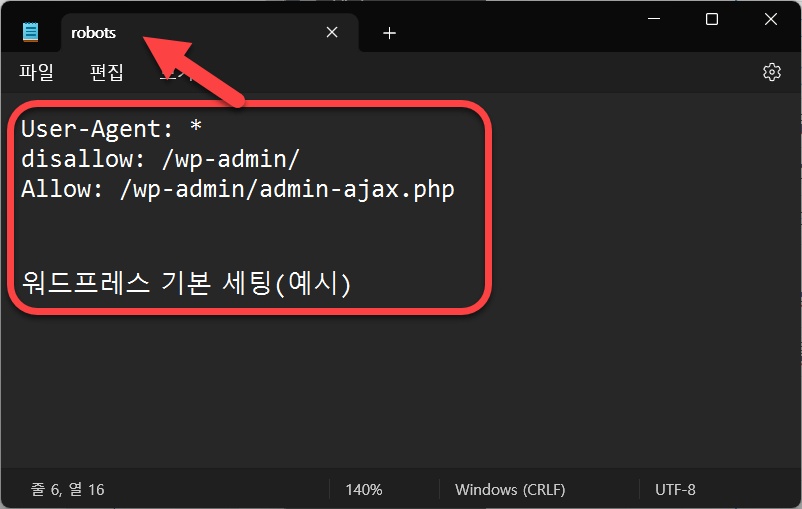

1. 메모장으로 robots.txt 파일 만들기

윈도우 메모장을 실행 후 규칙 작성합니다. 작성 후 파일명을 robots.txt로 저장합니다.

(워드프레스 기본 세팅) – 본문을 참고하여 변형하거나 추가하시면 됩니다.

user-agent: *

disallow: /wp-admin/

allow: /wp-admin/admin-ajax.php

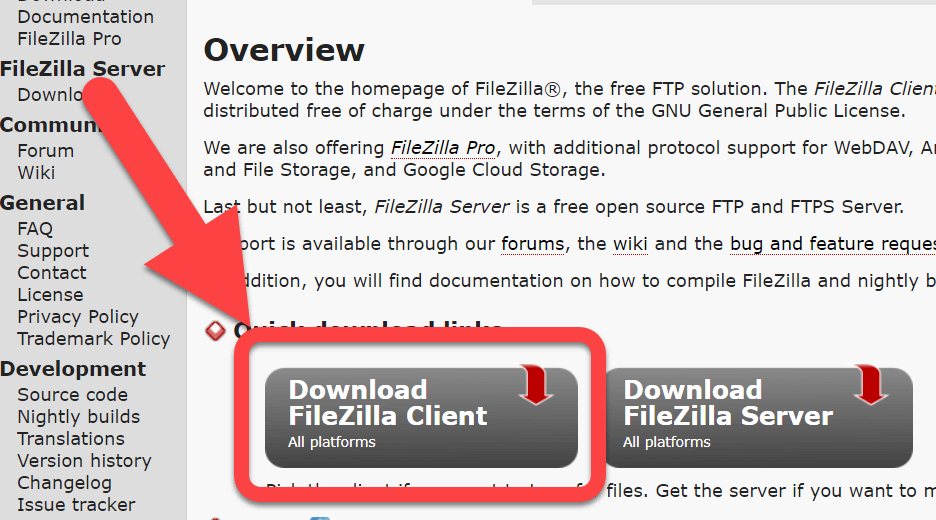

sitemap:________________2. 파일질라(FileZilla) 설치하기

홈페이지에서 [FileZilla Client] 용으로 다운로드 후 설치합니다.

3. 파일질라(FTP)로 robots.txt 업로드하기

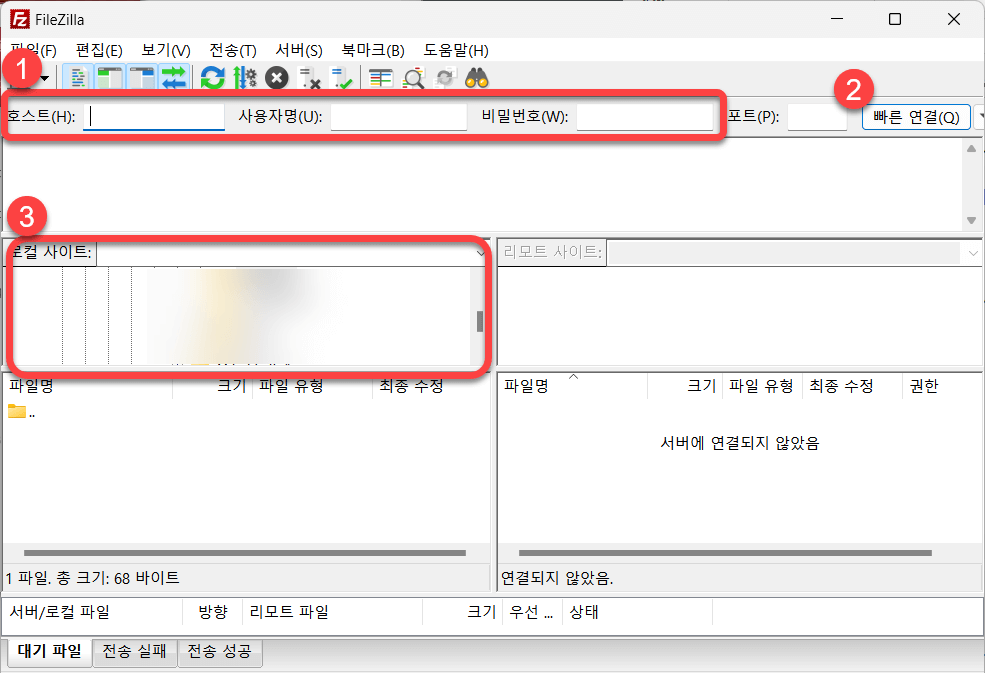

앞서 설치한 파일질라를 실행합니다.

1. 호스트(호스팅 관리페이지 확인), 사용자명, 비밀번호를 입력합니다.

2. [빠른 연결]을 클릭하여 사이트와 연결합니다.

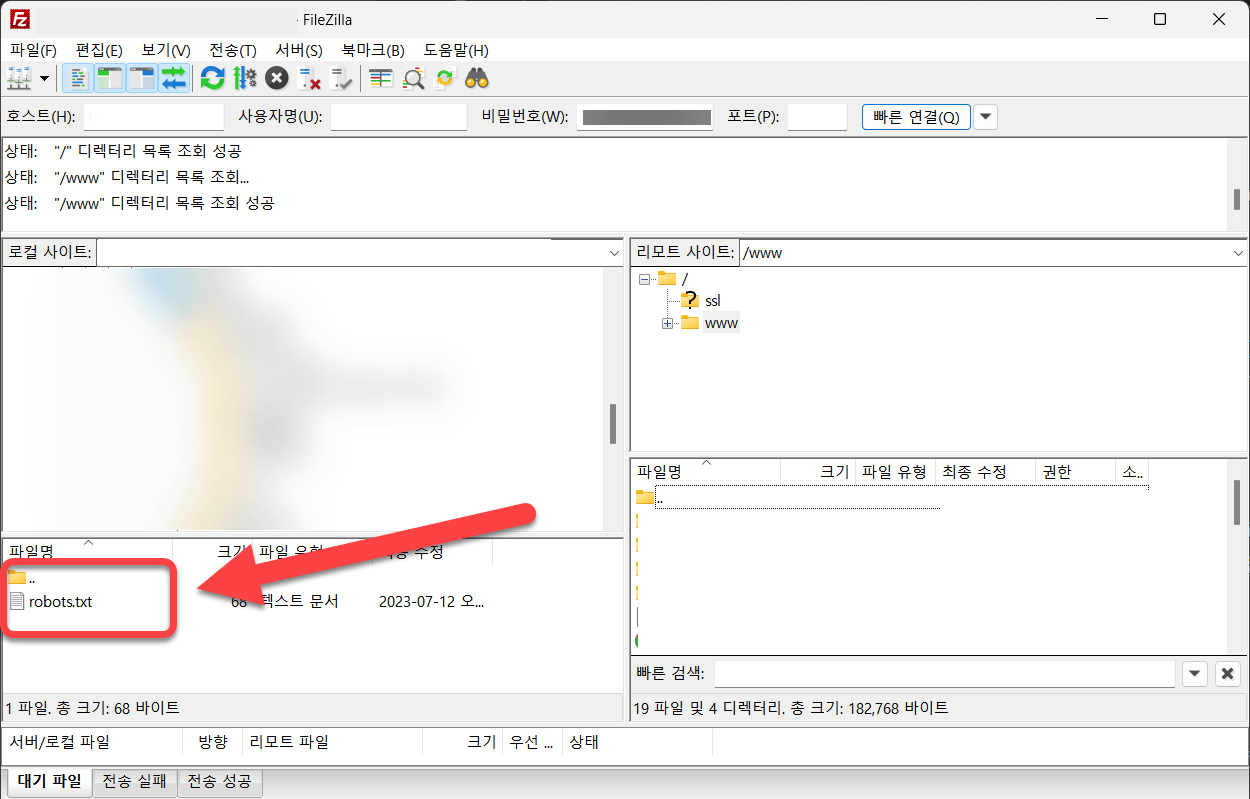

3. [로컬 사이트]에서 앞서 생성한 robots.txt 파일 경로로 이동합니다.

robots.txt 파일을 [우 클릭] 후 [업로드]를 선택하여, 업로드를 완료합니다.

Robots.txt 편집 방법(플러그인)

최초에 SEO 플러그인으로 robots.txt 파일을 생성한 경우 해당 플러그인 설정에서 수정이 가능합니다. 하지만 워드프레스 수동 설치와 함께 robots.txt파일을 생성했다면 “Robots.txt file is not writable” 또는 “robots.txt 파일을 쓸 수 없습니다”라는 문구와 함께 수정이 불가능합니다. SEO 플러그인에서 수정이 불가능한 경우 아래 2번 본문 바로가기를 클릭해서 진행하시면 됩니다.

- 본문 바로가기: SEO플러그인으로 robots.txt를 생성한 경우

- 본문 바로가기: SEO플러그인에서 수정이 안될 경우

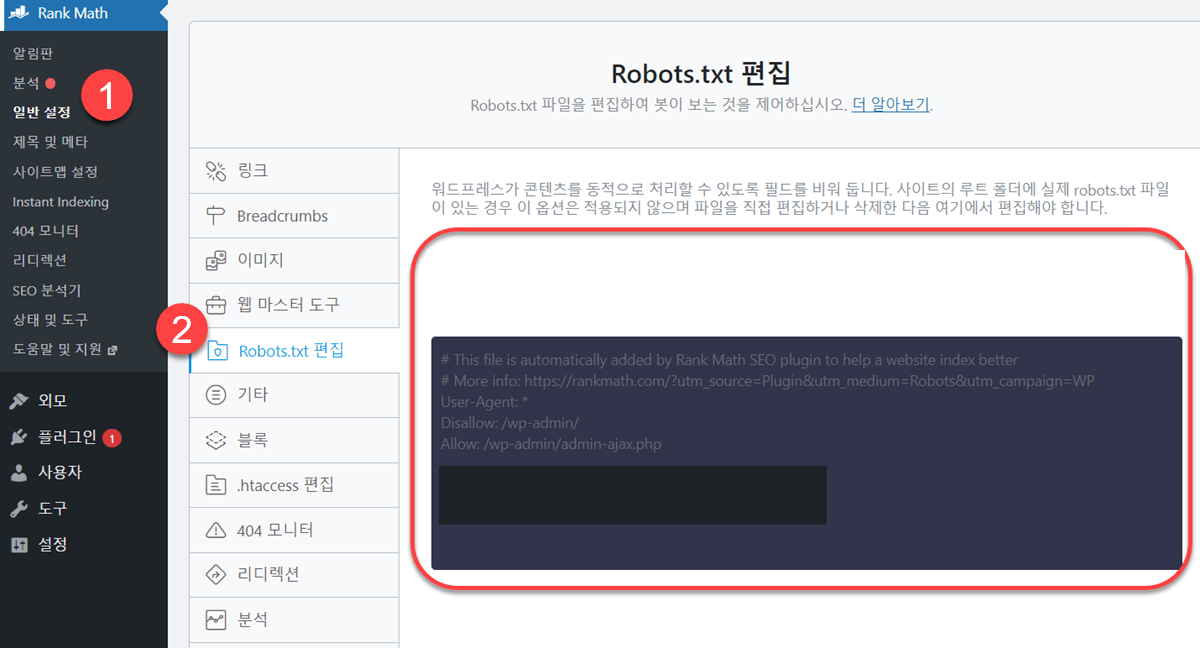

1. RankMath 플러그인 robots.txt 수정 방법

왼쪽 메뉴의 [Rank Math] → [일반 설정] → [Robots.txt 편집]에서 수정이 가능합니다.

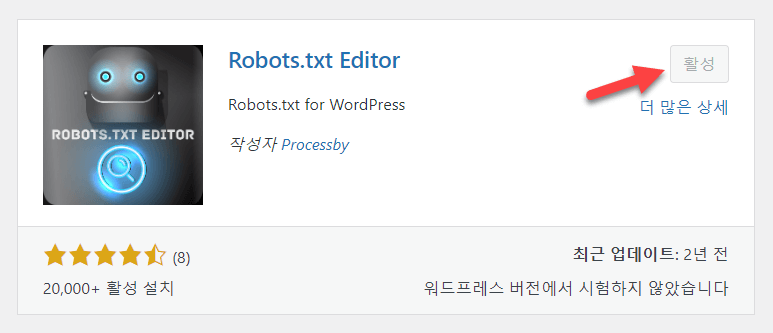

2. Robots.txt Editor 플러그인

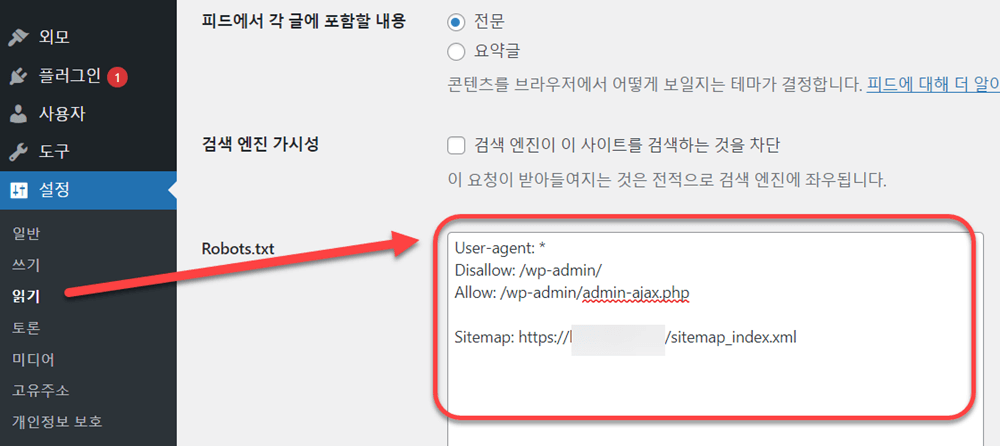

Robots.txt Editor 플러그인을 활용하면 소개드린 방법 중, 제일 간단하게 파일을 생성할 수 있습니다. 아래 플러그인 설치 방법과 사용 방법을 따라 진행해 주세요.

Robots.txt Editor 설치 및 사용 방법

[플러그인] → [새로 추가] → [Robots.txt Editor] 검색하여 설치 후 활성화합니다.

[설정] → [읽기]로 이동하면 아래에 Robots.txt 항목이 새로 추가됩니다.

맺음말

오늘 소개 드린 robots.txt 수정 및 설정 방법에 대해 궁금증들이 해결되셨기를 바랍니다. Robots.txt 설정 방법에 정답은 없습니다. 사이트의 용도와 방향에 맞게 수정 및 테스트를 진행해서 최적화된 포맷을 찾는 것이 좋습니다.

워드프레스 헤더,바디,푸터, HTML 편집 방법(스크립트,메타 태그)